Введение в Edge-вычисления 2025

К 2025 году Edge-вычисления перестали быть просто модным термином, став фактически новой парадигмой IT-инфраструктуры. Мы наблюдаем настоящий исход вычислительных мощностей из централизованных облаков на периферию, ближе к источникам данных. Это уже не просто «туманные» намёки, а вполне осязаемый технологический сдвиг, кардинально меняющий подходы к архитектуре приложений.

Эволюция от облака к периферии

Путь от централизованных облачных дата-центров к распределённой периферии был скорее вынужденной необходимостью, нежели внезапным озарением. Лавинообразный рост данных с IoT-устройств и запросы на минимальные задержки буквально вытолкнули вычисления на самый край сети. Это уже не просто «облако», а сложный гибрид, где логика решения задач динамически мигрирует между ядром и конечными устройствами.

Ключевые драйверы развития Edge-архитектур

Что же подстёгивает этот стремительный переход к периферийным вычислениям? Помимо очевидного взрывного роста IoT-устройств, на первый план выходят требования к сверхнизкой задержке для систем реального времени, таких как автономный транспорт. Не менее важен и аспект конфиденциальности данных — их локальная обработка позволяет избежать рисков, связанных с передачей через публичные сети. Ну и, конечно, банальная экономия трафика, которая в масштабах крупных корпораций превращается в миллионы долларов.

Основные архитектурные паттерны

В 2025 году доминируют несколько ключевых подходов к организации вычислений на границе сети. Паттерн «Туманные вычисления» создаёт распределённую иерархию между облаком и устройствами, что здорово снижает задержки. Не менее популярна «Периферийная архитектура», где логика выполняется прямо на шлюзах или маршрутизаторах. А вот «Микродата-центры» предлагают компактные, автономные узлы для обработки данных вблизи их источника, что кардинально меняет подход к развёртыванию.

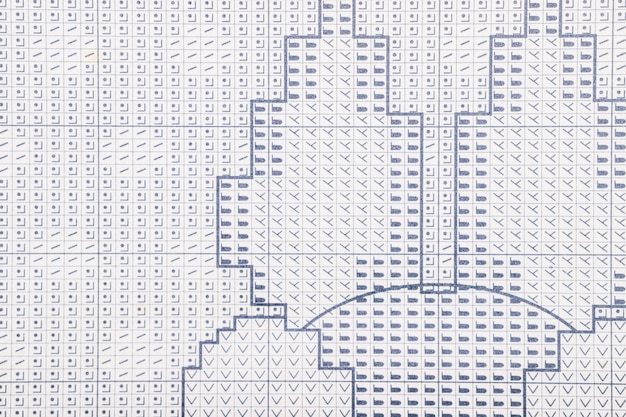

Трехуровневая архитектура: Cloud -> Fog -> Edge

Эта модель напоминает слаженный оркестр, где каждый музыкант знает свою партию. Облачный центр обрабатывает глобальные данные и сложные аналитические задачи, действуя как дирижёр. Fog-узел, расположенный ближе к источнику, агрегирует информацию с нескольких Edge-устройств, выполняя предварительную фильтрацию. Наконец, Edge-устройство реагирует мгновенно, принимая автономные решения в реальном времени. Такая иерархия эффективно распределяет нагрузку, минимизируя задержки.

Микросервисы и контейнеризация на Edge

На периферии сети классические монолиты просто нежизнеспособны. Здесь царствует парадигма микросервисов, упакованных в сверхлегкие контейнеры. Подумайте только: вместо громоздкой виртуальной машины — компактный образ в несколько мегабайт, способный мгновенно развернуться на скромном железе шлюза или маршрутизатора. Это уже не просто удобство, а суровая необходимость для обработки данных в реальном времени с минимальной латентностью.

Serverless (FaaS) для периферийных устройств

На периферии Serverless обретает новое звучание. Вместо гигантских облачных кластеров — легковесные функции, развернутые прямо на шлюзах или даже промышленных контроллерах. Это кардинально снижает задержки, ведь код выполняется в сантиметрах от источника данных. Правда, ограниченные ресурсы устройств заставляют пересматривать подходы к оптимизации. Но игра стоит свеч — такая модель открывает путь к подлинно автономным и мгновенно реагирующим системам.

Тренды и будущее развитие

К 2025 году мы увидим, как архитектурные паттерны начнут растворяться в самой периферийной среде. Вместо жёстких схем возникнет что-то вроде «архитектуры-призрака» — адаптивной, контекстно-зависимой и самоорганизующейся. Это уже не просто шаблоны, а скорее живые экосистемы, способные к импровизации в реальном времени. Интересно, куда это нас заведёт?

Фокус сместится на гибридные модели, где граница между edge, fog и облаком станет практически неразличимой. Появятся паттерны, предвосхищающие скачки сетевой задержки и проактивно распределяющие задачи. Это будет напоминать не столько инженерию, сколько симбиоз.

AI на границе сети: TinyML и нейросети

Поразительно, но сложные нейросети теперь ужимаются до размеров, позволяющих им работать на скромных микроконтроллерах. Это уже не лабораторные прототипы, а реальность, которую мы называем TinyML. Такие модели, будучи специально оптимизированными, выполняют локальный анализ данных — скажем, распознавание звука или вибрации — без необходимости в постоянном облачном соединении. Это кардинально снижает задержки и расходуемую энергию, открывая путь для truly автономных интеллектуальных устройств.

Управление с помощью Digital Twin

В 2025 году управлять распределённой периферийной инфраструктурой без цифрового двойника — почти что авантюра. Этот виртуальный слепок в реальном времени позволяет не просто мониторить, а буквально предсказывать поведение тысяч edge-устройств. Представьте: вы тестируете новую прошивку или алгоритм балансировки нагрузки не на живом кластере, а на его точной, изощрённой копии. Это кардинально снижает риски и ускоряет развёртывание, превращая управление из реактивного в проактивное. По сути, вы получаете полигон для экспериментов, где можно безопасно смоделировать даже самые экзотические сценарии нагрузки или сбоя.