Введение: Новая реальность ИИ

К 2027 году искусственный интеллект перестал быть просто инструментом, став полноправным участником социальных и экономических процессов. Это, в свою очередь, породило острую необходимость в создании гибких, но эффективных архитектур регулирования. Своего рода «правил дорожного движения» для цифрового разума, без которых дальнейшее развитие грозит обернуться хаосом.

От алгоритмов к архитектуре регулирования

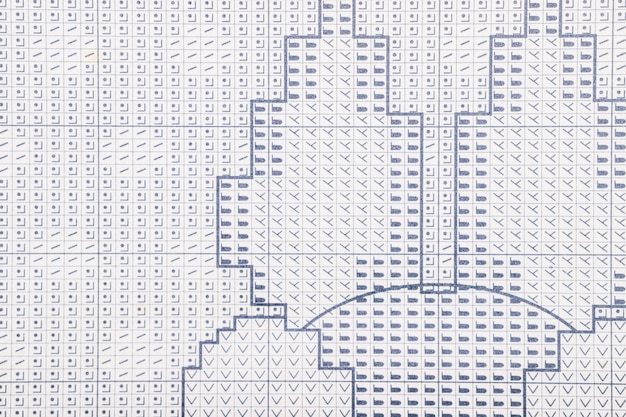

Вместо точечных запретов на отдельные алгоритмы, регуляторы к 2027 году, вероятно, перейдут к проектированию целостных архитектурных паттернов. Это похоже на создание градостроительного плана, где каждый элемент — данные, модель, интерфейс — должен вписываться в общую, безопасную и прозрачную структуру. Такой подход позволяет не просто реагировать на проблемы, а закладывать устойчивость к ним на системном уровне.

Почему 2027 год является ключевым рубежом?

К 2027 году многие прототипы ИИ перерастут в критически важные системы, интегрированные в энергетику, финансы и логистику. Откладывать создание регуляторного каркаса становится попросту опасно. Это тот самый момент, когда теория обязана встретиться с суровой практикой, иначе последствия могут быть необратимыми.

Ключевые архитектурные паттерны

К 2027 году наметилось несколько доминирующих подходов к построению регулируемых ИИ-систем. Пожалуй, наиболее перспективным выглядит паттерн «Архитектура сдержек и противовесов», где принятие ключевых решений распределено между несколькими независимыми модулями. Это создаёт внутреннюю систему проверок, усложняя выход системы из-под контроля. Параллельно набирает обороты концепция «Модульного суверенитета», позволяющая изолировать критические компоненты для их независимого аудита и сертификации.

Паттерн «Песочница»: Контролируемые среды для инноваций

Представьте себе своего рода цифровой полигон, где разработчики могут экспериментировать с алгоритмами, не опасаясь выйти за установленные рамки. Именно такую возможность предоставляет паттерн «Песочница». Это не просто изолированная среда, а скорее регулируемое пространство, где инновации сталкиваются с безопасностью, позволяя тестировать даже самые рискованные модели ИИ. По сути, это золотая середина между свободой творчества и необходимостью контроля, которая, вероятно, станет краеугольным камнем будущего регулирования.

Паттерн «Риск-ориентированное регулирование»

Вместо универсальных запретов, этот подход предлагает градацию. Представьте, что ИИ для рекомендации фильмов и система автономного вождения живут по разным правилам. Регулятор фокусируется на приложениях с высоким потенциалом вреда — скажем, в медицине или финансах. Для них требования к тестированию и прозрачности будут несопоставимо строже. Это позволяет не душить инновации там, где риски минимальны.

Паттерн «Человек в контуре» для критических систем

В сценариях, где цена ошибки ИИ неприемлемо высока — скажем, в медицинской диагностике или управлении автономным транспортом — на помощь приходит этот паттерн. Он не заменяет, а дополняет искусственный интеллект, встраивая оператора в ключевые точки принятия решений. Система может генерировать варианты или рекомендации, но финальное «добро» всегда остаётся за человеком. Это создаёт жизненно важный баланс между эффективностью алгоритма и человеческой ответственностью.

Технологии как основа регулирования

К 2027 году сама архитектура ИИ становится ключевым инструментом для его же контроля. Вместо громоздких внешних надзирателей, регуляторы вшиваются прямо в код. Представьте себе встроенные «предохранители», которые не дают алгоритму принять опасное решение, или системы автоматического аудита, отслеживающие каждое действие модели в реальном времени. Это уже не просто правила, а технологический скелет безопасности.

Роль блокчейна для аудита и прозрачности

Представьте себе неизменяемый цифровой журнал, куда записывается каждое решение, принятое ИИ-системой. Блокчейн предлагает именно это — создание децентрализованного и криптографически защищённого реестра. Такой подход кардинально меняет аудит, предоставляя регуляторам и разработчикам неопровержимую и прозрачную цепочку данных для анализа. Это уже не просто теория, а насущная необходимость для построения доверия.

Стандартизация интерфейсов и метаданных

К 2027 году, по всей видимости, сформируется настоятельная потребность в унифицированных протоколах обмена данными между разнородными ИИ-системами. Речь идёт не просто о совместимости, а о создании своего рода лингва франка для искусственного интеллекта. Без этого мы рискуем получить хаос из «вещь в себе» — изолированных моделей, неспособных к эффективному взаимодействию.

Ключевым элементом станут стандартизированные метаданные, описывающие происхождение данных, использованных для обучения, их качество и возможные смещения. Это что-то вроде технического паспорта или, если угодно, «пищевой ценности» для алгоритма, что критически важно для аудита и доверия.